近日,中國科學(xué)院上海微系統(tǒng)與信息技術(shù)研究所仿生視覺系統(tǒng)實驗室李嘉茂研究員團隊在雙目立體視覺深度估計領(lǐng)域取得重要進展。題目為“F2R2: Frequency Filtering-based Rectification Robustness Method for Stereo Matching”的成果被機器人領(lǐng)域頂級國際學(xué)術(shù)會議2025 IEEE International Conference on Robotics and Automation(ICRA)錄用。

雙目立體視覺通過模擬人類雙眼原理,基于兩個相機從不同視角拍攝同一場景圖像,通過計算對應(yīng)像素點的視差(Disparity)進而恢復(fù)空間深度(Depth)信息,這一過程即為立體匹配(Stereo Matching)。該技術(shù)是自主智能機器人、智能駕駛、元宇宙、工業(yè)檢測、醫(yī)療自動化等眾多領(lǐng)域的基礎(chǔ)關(guān)鍵技術(shù)。

經(jīng)典立體匹配問題中,要求雙目圖像滿足嚴格的極線約束前提。主流的做法是借助標(biāo)定板對雙目系統(tǒng)進行高精度的離線預(yù)標(biāo)定與立體校正,并假設(shè)在后續(xù)使用過程中相機系統(tǒng)參數(shù)保持穩(wěn)定。然而,在實際應(yīng)用環(huán)境中,雙目系統(tǒng)往往會受到諸如碰撞、長期機械振動和溫度變化等因素的影響,從而導(dǎo)致雙目系統(tǒng)的外部參數(shù)發(fā)生偏移,從而顯著降低深度估計精度,甚至導(dǎo)致算法的崩潰。為應(yīng)對這一問題,眾多研究者提出了基于場景特征的在線自標(biāo)定與校準(zhǔn)技術(shù),旨在實時估計雙目系統(tǒng)的姿態(tài)變化并進行修正。盡管如此,校正后的圖像仍可能存在分布不均的校正誤差,且此類方法在視覺特征稀疏場景下易失效,難以保證應(yīng)用的穩(wěn)定性。

為此,團隊另辟蹊徑,聚焦弱約束雙目立體視覺深度估計研究,直接對未經(jīng)過嚴格極線校正的雙目圖像進行深度估計。具體地,團隊提出了一種基于頻率濾波的立體匹配方法F2R2。該方法從頻域?qū)W習(xí)的角度出發(fā),通過設(shè)計敏感頻率濾波策略與匹配特征重構(gòu)模塊,增強模型對于校正誤差的魯棒性,同時有效保證了視差預(yù)測精度。該方法具有即插即用的特性,可適用于不同的立體匹配基礎(chǔ)模型。團隊基于PSMNet 、Gwc-Net等經(jīng)典模型,在多個添加合成誤差的公開數(shù)據(jù)集KITTI2015(KT15),KITTI2012(KT12),Middlebury(MB),ETH3D(ET)和帶有真實誤差的自采集數(shù)據(jù)上完成了驗證,改進后的模型在不同程度的外參擾動下均表現(xiàn)出良好的性能。

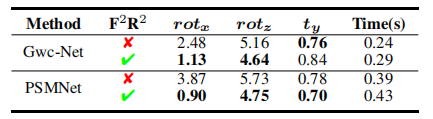

在多個權(quán)威雙目數(shù)據(jù)集上,團隊算法F2R2在外參擾動下顯著提升模型魯棒性(表中為立體匹配EPE(End Point Error)誤差,數(shù)值越小,性能越高)

在自采集數(shù)據(jù)集上,團隊算法F2R2在外參擾動下顯著提升模型魯棒性(表中為立體匹配EPE(End Point Error)誤差,數(shù)值越小,性能越高)

本研究成果得到了科技部科技創(chuàng)新2030、國家自然科學(xué)基金、上海市自然基金、中國科學(xué)院青促會、上海市優(yōu)秀學(xué)術(shù)帶頭人等項目支持。上海微系統(tǒng)所仿生視覺系統(tǒng)實驗室周昊龍博士研究生、朱冬晨研究員為論文共同一作,李嘉茂研究員為通訊作者。